44

SBM’den ·

From SBM

ETL (Extract - Transform - Load)

Veri ambarlarının, kaynak sistemlerden beslenmesi

ve güncellenmesi işlemine ETL adı verilmektedir.

Kavramsal ve mantıksal modeller fiziksel

veri tabanları olarak tanımlandıktan sonra,

kaynaktaki verilerin dönüştürülerek veri ambarına

yüklenmesine yani ETL işlemine başlanır. ETL

geliştirmeleri öncesinde kaynaktaki tabloların

veri ambarındaki tablolar ile eşleştirmeleri

yapılr, verinin nasıl dönüştürüleceği belirlenir ve

dokümante edilir. Buna göre, ETL işleri geliştirilir.

Ayrıca bu eşleştirme sayesinde kaynak ile hedef

arasındaki yapısal boşluklar görülür.

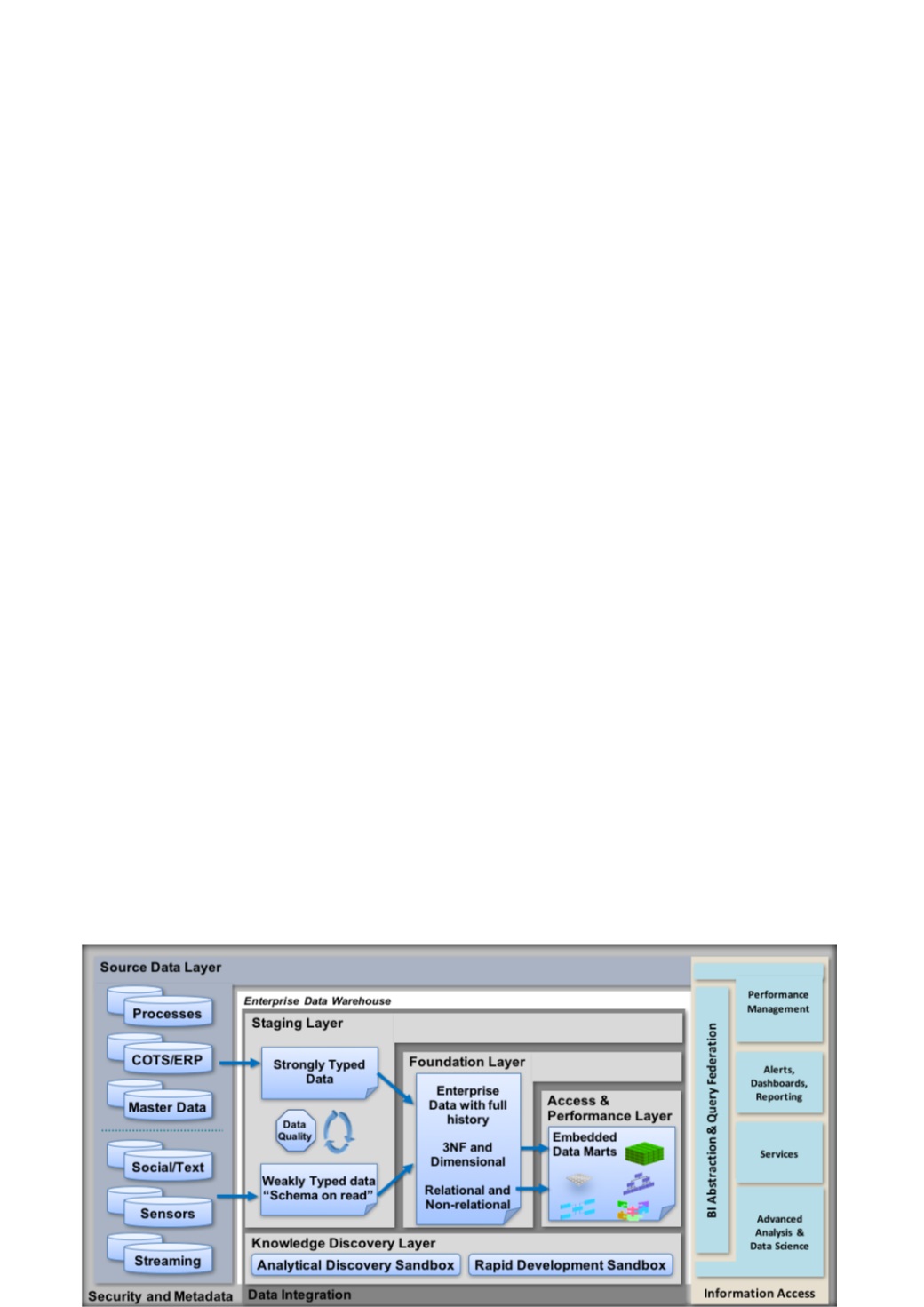

Projede, Oracle veri ambarı referans mimarisinin

önerdiği metodları izledik. Kaynak sistemleri

rapor sorguları ile yormamak için kaynaktaki

verileri öncelikle, olduğu gibi Veri Ambarının

ilk katmanına (Operational Data Store - ODS -

Staging Layer) aldık. Verileri, ODS'e herhangi bir

dönüşüme uğratmadan, aynen kopyadık. İkinci

katmanda (Foundation Layer), ODS'ten aldığımız

verileri, ilişkisel olarak modellediğimiz yapıya tüm

tarihselliği ile beraber aktardık. Yine bu katmanda

3NF tasarlanan boyut tablolarını günlük olarak

besledik.

Son katmanda (Access & Performance Layer),

ikinci katmanda en dip seviyede hazırlanan verileri

özetledik ve gerekli indeksleme, tablo bölmeleme

gibi yöntemlerle performanslı sorgulama için hazır

hale getirdik. Tüm bu ETL işlemleri sonucunda,

raporlama katmanında kullanılacak KPI'lar için

gereken alanları algoritmalarla hesaplamış ve

artırımsal biçimde veri ambarına yazmış olduk.

Günlük işlem yükünü optimize ederek istatistiki

veri setlerini zamanında raporlamaya hazır hale

getirdik.

ETL (Extract - Transform - Load)

ETL is a common definition of feeding and updating

data warehouses from source systems. After

defining conceptual and logical models as physical

databases in thewarehouse, data is being extracted

from source systems, transformed and loaded

into the warehouse by the ETL process. Before

ETL, operational system tables are mapped to the

data warehouse model, and the transformation

algorithms are documented. According to this,

ETL jobs are developed. In addition, structural gap

between the source and target databases can be

reported with this mapping.

Following themethodsofOracle'sDataWarehouse

ReferenceArchitecture, first of all, data is loaded as

is without any transformation from source tables

to ODS (Operational Data Store - ODS - Staging

Layer) tables to avoid over utilizing transactional

system with select queries. At the second layer

(Foundation Layer), fact data is transferred from

ODS to RDS (structured & modelled relational

data store) with all historical information. Also in

this layer, we daily fed dimension tables that are

designed 3NF here.

Finally in the last layer (Access & Performance

Layer), we have summarized the detailed data

and made ready for high performance querying by

methods like indexing and table partitioning. So, at

the end of all these ETL processes, we have written

calculated fields necessary for all KPI’s that are

used at the reporting layer. The transformations

and inserts are done in an incremental manner, so

the statistics are ready on time for daily processing.

We developed ETL processes on last version of

Oracle Data Integrator (ODI 12c) and started to use

a Scheduler tool developed by Oracle Consulting.